Compartimos en Edugestores este artículo de César Guadalupe, publicado en su blog Satyagraha:

Retomo este blog luego de mucho tiempo y lo hago en el contexto de la publicación de los resultados de la versión 2018 de la Evaluación Censal de Estudiantes (ECE). De hecho, ya había pensado tocar este tema y hace varios meses preparé un brevísimo borrador que dice lo siguiente:

En unas semanas más se publicará los resultados de la ECE 2018. Con total seguridad, ésta mostrará tímidos progresos en los grados evaluados; una diferencia en los desempeños entre escuelas del Estado y escuelas no estatales (la misma que desaparece luego de controlar las diferencias socio-económicas); disparidades que afectan negativamente a las zonas rurales; y un ranking de departamentos muy similar a los que se han publicado en las 10 versiones previas de la prueba. Además, los que hagan un análisis posterior más detenido, mostrarán que el sistema educativo peruano presenta muy marcados niveles de segregación social y que, por lo tanto, tiende a reproducir desigualdades.

Es decir, la ECE 2018 no nos dice nada que no sepamos ya.

Sin embargo, ahora que se ha publicado los resultados, este texto funciona bien para todos los grados evaluados menos para segundo de primaria y cuarto grado EIB. ¿Qué pasó?

Déjenme ser muy claro y directo: no hay una explicación definitiva de estos resultados y difícilmente la tengamos porque no tenemos suficiente evidencia sistemática para tenerla. Lo que podemos plantear son explicaciones plausibles. De eso se trata el resto de este texto.

Lo primero que quiero mencionar es que una explicación cataclísmica podría dar cuenta de modo parcial de lo observado; pero, difícilmente las cosas se explican sólo por ello. Si bien la huelga de 2017, el fenómeno del niño, y (según algunos críticos) la gestión de Idel Vexler podrían tener un impacto negativo, éste afectaría a todos los grados y no sólo a segundo de primaria. Por lo tanto, hay que buscar una explicación específica para dicho grado. Ciertamente, es posible que algunos de estos eventos hayan tenido un impacto particular en los niños que cursaron segundo de primaria en 2018 (los afectó en primer grado que es un grado potencialmente muy sensible por lo que podría esperarse un efecto diferente de lo observado en grados posteriores), pero la magnitud de los cambios sugeriría que hay algo más en esta historia.

Quienes trabajamos en este tema sabemos que es muy difícil tener evaluaciones estandarizadas que arrojen resultados robustos y comparables (entre personas y en el tiempo) cuando se trabaja con grados tempranos. Los principales promotores de la evaluación en grados tempranos (RTI International) siempre se han opuesto a que se fije estándares comunes (como decodificar 60 palabras por minuto sin importar la lengua y el sistema de escritura), o que se agregue la información como si fuese comparable, y han promovido pruebas administradas de modo individual y con un importante componente oral. Esto obedece a múltiples factores que incluyen, por ejemplo, la influencia de la lectura en una prueba de matemáticas: si un niño tiene dificultad para leer el cuestionario de matemáticas, ¿sus respuestas dan cuenta de una debilidad en matemáticas? Por supuesto que no necesariamente y ése es el problema: al final uno no sabe qué es lo que está midiendo ya que la medida es distorsionada por un factor adicional del que uno puede no ser consciente.

Esto explica porque, desde que se tomó la decisión, en 2006, de crear las ECE en segundo grado de primaria, la hoy Oficina de Medición de la Calidad de los Aprendizajes (UMC) ha propuesto formas alternativas de evaluar el sistema. En particular, siempre ha buscado tener un plan sistemático de evaluaciones (muestrales) que permita mejor cobertura curricular en un número mayor de grados. Asimismo, diversas voces especializadas en este tema, han señalado lo mismo a todos los ministros desde 2006. Entonces, ¿por qué hay ECE de segundo grado y por qué se mantiene? Este es un tema que amerita un análisis específico que no es motivo de este post.

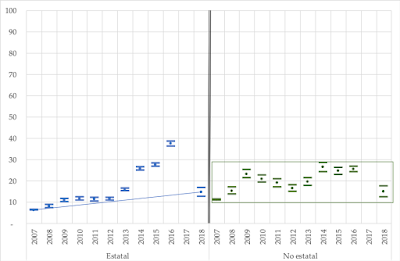

Con esto en mente, veamos los resultados. No los de 2018 en aislamiento, tampoco los últimos dos años (recordando que la ECE de 2017 fue suspendida), sino toda la serie desde 2007. Asimismo, usemos la información muestral (la ECE 2018 de segundo de primaria fue muestral y todos los años se hizo una “muestra de control” que es la que genera los resultados que pueden considerarse robustos; esto se explica en un post de hace 6 años y disponible acá). Al usar muestras debemos incluir tanto los estimadores (puntos) como el intervalo (marcado con líneas) en que se encuentra el valor poblacional con una certeza conocida (en este caso, del 95 por ciento). Este gráfico muestra el porcentaje de estudiantes con desempeño satisfactorio en matemáticas.

Como notará cualquier persona con un mínimo de formación estadística, los datos agregados del sector no estatal son erráticos y no se mueven mayor cosa dentro de los márgenes definidos por el recuadro verde que he añadido. Los resultados agregados en lasescuelas estatales tienen una tendencia sostenida (aunque muy tímida y marcada con la línea azul que he añadido) al crecimiento con tres valores que, evidentemente, no se ajustan a esta tendencia (esos tres años también son levemente diferentes en el caso de las escuelas no estatales) ya que muestran un crecimiento muy marcado. Tómese en cuenta, además, que ambos sectores son muy heterogéneos, por lo que las comparaciones entre valores agregados tienen siempre un valor referencial. Mi intención al presentar de modo separado lo estatal y lo no estatal es indagar si cabe postular la existencia de algún factor que afecte de modo diferenciado a las escuelas según su gestión y, claramente, encontramos patrones distintos.

|

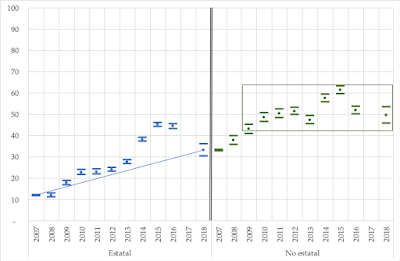

En el caso de lectura, tenemos lo siguiente:

|

| Porcentaje de estudiantes con desempeño satisfactorio en lectura. Evaluación Censal de Estudiantes 2007-2018. Elaboración propia a partir de la serie de datos publicada por la UMC y disponible en su sitio web (http://umc.minedu.gob.pe) y el informe de resultados de 2018 |

Nuevamente se aprecia un estancamiento en el comportamiento agregado de la educación no estatal y una tendencia al progreso sostenido (más marcada que en matemáticas como muestra la línea azul añadida) en el agregado de las escuelas estatales con los mismos tres datos atípicos (dos de esos tres años sugieren progresos con un patrón similar en el caso no estatal).

Asimismo, hay que considerar que las diferencias entre 2018 y 2016 son mucho más marcadas en matemáticas que en lectura: los puntos de caída en matemáticas representan el 60 por ciento del valor anterior, y 25 por ciento en lectura. Esto va de la mano con que el alza entre 2013 y 2016 también fue mucho mas marcada en esa área (137 por ciento en matemáticas y 61 por ciento en lectura).

Por otra parte, debemos considerar que toda la información adicional que tenemos sobre niveles de aprendizaje (PISA, estudios del Laboratorio Latinoamericano, ECE de otros grados) muestra, a pesar de sus limitaciones, que hay un progreso sostenido (aunque lento) desde al menos 2001. Esto es coherente con las líneas de tendencia antes mostradas y brinda información adicional para preguntarse por la atipicidad de los datos correspondientes al período 2014-2016.

Entonces, hay dos opciones lógicas: o tuvimos una espectacular mejora entre 2014 y 2016 y luego caímos; o los resultados de 2014-2016 están “inflados” por alguna razón y, entonces, son outliers que deben ser descartados y constatar que seguimos en la misma tendencia.

Desde el inicio de las ECE, muchas personas hemos observado (en base a la experiencia y la abundante evidencia disponible) que no eran una buena idea. Las razones siempre han sido éstas:

(i) una evaluación censal produce menos información y menos confiable que una muestral;

(ii) una evaluación censal es muy visible y, por lo tanto, puede ejercer una presión indebida sobre el sistema ya que por medir muy pocos aspectos implica el riesgo de estrechamiento curricular (se prioriza lo que está en la prueba y se descuida todo lo demás que está en el currículo), preparación para la prueba, o fraudes, todos elementos que perjudican los aprendizajes;

(iii) al contarse con información con este nivel de desagregación, alguien con una comprensión muy limitada de estos temas (y abusando del acceso público a la información) puede elaborar un ranking que, al no controlar condiciones que intervienen, terminan sirviendo únicamente para estigmatizar y reforzar prejuicios.

(iv) las pruebas estandarizadas son una foto de un proceso complejo que captura una fracción muy limitada de la realidad; por lo mismo, dichas pruebas son útiles para análisis agregados que alimenten políticas y recomendaciones que retroalimenten al sistema, pero potencialmente muy riesgosas y equívocas respecto de situaciones locales o individuales específicas.

Así, una evaluación censal, sólo tendría sentido para:

(i) alimentar un esquema de micro-management desde el Ministerio que, además de riesgoso e inoperante, perpetúa las debilidades en las instancias de gestión fuera de éste;

(ii) motivar a todos los actores del sistema, aunque esta motivación puede fácilmente ser mal dirigida (a subir puntajes y no a mejorar la educación) y lograrse con menos riesgos por otros medios; e

(iii) identificar situaciones particularmente críticas que requieren de apoyo urgente, cosa que no ha sido una preocupación consistentemente sostenida en el país.

Para aprender acerca de cómo estamos y para obtener recomendaciones pedagógicas y de política, las evaluaciones muestrales son infinitamente más útiles y pertinentes, brindan más información y carecen de los riesgos asociados a las censales (rankings, sobrevaluar una medida parcial e imperfecta, asociar instrumentos de gestión a dicha medida, estrechamiento curricular, entrenamiento para la prueba, etc.).

Por ello, la pieza de evidencia más importante que deberíamos considerar al discutir estos temas es la investigación conducida hace más de 40 años y que llevó a la formulaciones de las llamadas Leyes de Campbell. Estas básicamente dicen lo siguiente: cuando uno le da demasiada importancia a un indicador singular produce dos resultados; primero, que la acción de las personas se oriente a alterar el indicador y no la realidad que éste pretende medir; y, segundo y como resultado de lo anterior, el indicador deja de medir lo que se suponía que medía.

Con estos elementos en mente es posible entender por qué diversas investigaciones conducidas en los últimos años (por ejemplo, este texto de Eduardo León, o éste que hicimos con Luis Eduardo Castillo) y la observación de aula de cualquiera de los que hacemos trabajo de campo regularmente, han coincidido en registrar que diversos gobiernos regionales, órganos de gestión intermedia (UGEL) e instituciones educativas (estatales y no estatales) han tendido a hacer campañas de entrenamiento para la prueba que distorsionan la medición. A esto se ha sumado un conjunto de acciones del propio Ministerio que van desde la producción de materiales que han sido usados para el entrenamiento -los “Kits de evaluación” (más allá de la buena intención con la que se produjeron), hasta vincular de modo compulsivo una parte importante de la gestión a la ECE de segundo grado de primaria, la misma que fue tomada como el supremo e indicutible indicador de “resultados”, y el Bono Escuela que muchos consideramos, desde su planteamiento inicial, un desacierto (el propio Consejo Nacional de Educación publicó, en 2014, un documento crítico que anticipa los problemas que hoy vemos).

A esto debemos agregar que, como sabemos por lo observado en muchos casos, es más fácil entrenar para los “trucos” de una prueba de matemáticas que para leer. Entonces, es esperable que el área con mayor volatilidad en resultados (mayores subidas entre 2013 y 2016 y mayor caída a 2018) haya sido, justamente, el área matemática.

Así, es perfectamente plausible afirmar que el sistema educativo ha sufrido una fuerte presión alrededor de la ECE de segundo de primaria, especialmente las escuelas del Estado, y que ésta se ha exacerbado durante el período 2014-2016 cuando se introdujo el Bono Escuela, y se sobreenfatizó el valor de estos datos para la gestión. Esto habría producido resultados perfectamente coherentes con las Leyes de Campbell los mismos que se manifiestan, de modo más marcado (pero no exclusivo), en el período 2014-2016. Asimismo, al cambiar el carácter de la evaluación de segundo grado de primaria (pasar a muestral y, por lo tanto, no atar el Bono Escuela a ella) a lo que se suma los cambios en los mensajes que sobre esta evaluación han tenido las últimas gestiones (todas desde diciembre de 2016), esa presión ha tendido a desaparecer.

Así, yo apostaría por este elemento explicativo (recordando que los problemas complejos suelen tener explicaciones múltiples que perfectamente pueden incluir los elementos mencionados al inicio de este texto). Por lo mismo, consideraría que debemos, simplemente, no prestar mayor atención a estos resultados ya que la ECE ha dejado de medir lo que se suponía debía medir o, en el peor de los casos, considerar que tenemos una serie de datos de la que hay que excluir los resultados de 2014 a 2016.

Aunque, en realidad, habría que desechar las evaluaciones censales in toto, y pasar a un sistema más inteligente que se base en evaluaciones muestrales con mayor cobertura curricular (más áreas, más grados, más profundidad), que permita no sólo tener una imagen general del sistema sino también producir recomendaciones pedagógicas; al tiempo que el reforzamiento de la gestión escolar incluye herramientas de autoevaluación que habrían de incorporar (pero no limitarse a) resultados de pruebas que ellas mismas administren (con apoyo del Ministerio) y que, por tanto, no serían comparables y no habría interés en hacerlas lucir mejor de lo que son.

Finalmente, esto supone también plantearse que la producción de información de gran trascendencia e impacto debe estar en manos de unidades que gocen de autonomía técnica para decidir acerca de qué hacer sin que dichas decisiones se vean afectadas por arrebatos presidenciales (como el que creó la ECE en 2006) o visiones ideológicas que se despliegan en la gestión sin contrapeso alguno. Si en vez de contar con una unidad dentro del Ministerio, hubiésemos construido una organización autónoma que reporte a un Consejo Directivo independiente que reúna una diversidad de puntos de vista informados sobre estos temas, nunca hubiésemos tenido una evaluación censal, ni los problemas (reales o ficticios) que hoy vemos. Es urgente, entonces, pensar en que unidades como la UMC y Estadística debieran salir del Ministerio y contar con una forma institucional que les permita operar de una mejor manera.

Fechado el 9 de abril de 2019.